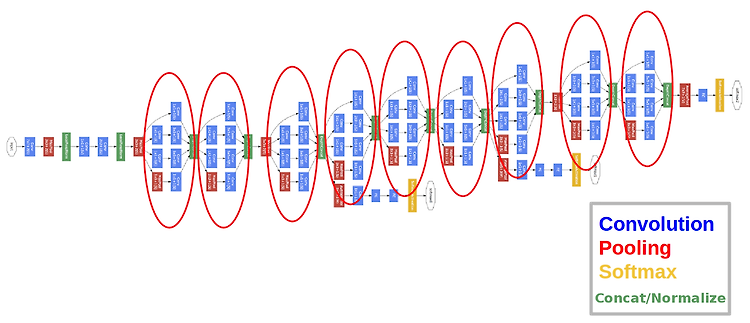

스터디날짜: 2020. 02. 06 목요일 스터디장소: 온라인(행아웃) 스터디 주제: R-CNN R-CNN이란 무엇인가? 이미지를 classify하고 이미지 내의 위치를 탐지하는 object detection을 하기 위해 cnn을 사용하는 방식이다. R-CNN의 진행 순서 및 모듈 1. R-CNN은 이미지에 대한 후보 영역을 생성 2. 고정된 크기로 warping/crop하여 CNN 인풋으로 사용 3. SVM(Support Vector Machine)을 이용하여 Classification을 진행 그러나 R-CNN은 느리다는 치명적인 단점이 있다. 이를 보완하기 위해서 Fast R-CNN, Faster R-CNN등이 등장하였다. Fast R-CNN은 각각의 물체를 CNN하느라 소모되는 시간을 줄이기 위해 ..